Wie der Name schon sagt, ist Backpropagation ein Algorithmus Dadurch werden die Fehler von den Ausgabeknoten an die Eingabeknoten zurückgegeben. Daher wird es einfach als 'Rückwärtsausbreitung von Fehlern' bezeichnet. Dieser Ansatz wurde aus der Analyse eines menschlichen Gehirns entwickelt. Spracherkennung, Zeichenerkennung, Signaturüberprüfung und Gesichtserkennung sind einige der interessanten Anwendungen neuronaler Netze. Die neuronalen Netze durchlaufen überwachtes Lernen, der durch das Netzwerk laufende Eingabevektor erzeugt einen Ausgabevektor. Dieser Ausgabevektor wird gegen die gewünschte Ausgabe verifiziert. Wenn das Ergebnis nicht mit dem Ausgabevektor übereinstimmt, wird ein Fehlerbericht generiert. Basierend auf dem Fehlerbericht werden die Gewichte angepasst, um die gewünschte Ausgabe zu erhalten.

Was ist ein künstliches neuronales Netzwerk?

Ein Künstliche neuronale Netz setzt überwachte Lernregeln ein, um effizient und leistungsfähig zu werden. Die Informationen in neuronalen Netzen fließen auf zwei verschiedene Arten. In erster Linie, wenn das Modell trainiert oder gelernt wird und wenn das Modell normal funktioniert - entweder zum Testen oder zur Ausführung einer Aufgabe. Informationen in verschiedenen Formen werden über Eingangsneuronen in das Modell eingespeist, wodurch mehrere Schichten versteckter Neuronen ausgelöst werden und die Ausgangsneuronen erreicht werden, die als Feedforward-Netzwerk bezeichnet werden.

Da nicht alle Neuronen gleichzeitig ausgelöst werden, werden die Neuronen, die die Eingaben von links erhalten, mit den Gewichten multipliziert, wenn sie sich durch verborgene Schichten bewegen. Addieren Sie nun alle Eingaben von jedem Neuron. Wenn die Summe einen bestimmten Schwellenwert überschreitet, werden die still stehenden Neuronen ausgelöst und verbunden.

Das künstliche neuronale Netzwerk lernt, indem es aus dem lernt, was es falsch gemacht hat und das Richtige tut. Dies wird als Feedback bezeichnet. Künstliche Neuronale Netze verwenden Feedback, um herauszufinden, was richtig und was falsch ist.

Was ist Backpropagation?

Definition: Backpropagation ist ein wesentlicher Mechanismus, mit dem neuronale Netze trainiert werden. Dies ist ein Mechanismus zur Feinabstimmung der Gewichte eines neuronalen Netzwerks (in diesem Artikel auch als Modell bezeichnet) in Bezug auf die in der vorherigen Iteration erzeugte Fehlerrate. Es ähnelt einem Boten, der dem Modell mitteilt, ob das Netz einen Fehler gemacht hat oder nicht, sobald es vorhergesagt hat.

Backpropagation-Neuronales-Netzwerk

Bei der Backpropagation in neuronalen Netzen geht es um die Übertragung von Informationen und Beziehen dieser Informationen auf den Fehler, der vom Modell generiert wurde, als eine Vermutung angestellt wurde. Diese Methode versucht, den Fehler zu reduzieren, der auch als Verlustfunktion bezeichnet wird.

Wie Backpropagation funktioniert - Einfacher Algorithmus

Backpropagation beim Deep Learning ist ein Standardansatz für das Training künstlicher neuronaler Netze. So funktioniert es: - Wenn zunächst ein neuronales Netzwerk entworfen wird, werden Zufallswerte als Gewichte zugewiesen. Der Benutzer ist sich nicht sicher, ob die zugewiesenen Gewichtswerte korrekt sind oder zum Modell passen. Infolgedessen gibt das Modell den Wert aus, der sich von der tatsächlichen oder erwarteten Ausgabe unterscheidet, bei der es sich um einen Fehlerwert handelt.

Um die entsprechende Ausgabe mit minimalem Fehler zu erhalten, sollte das Modell auf einen relevanten Datensatz oder Parameter trainiert werden und seinen Fortschritt jedes Mal überwachen, wenn es vorhergesagt wird. Das neuronale Netzwerk hat eine Beziehung zum Fehler. Wenn sich also die Parameter ändern, ändert sich auch der Fehler. Die Rückausbreitung verwendet eine Technik, die als Delta-Regel oder Gradientenabstieg bekannt ist, um die Parameter im Modell zu ändern.

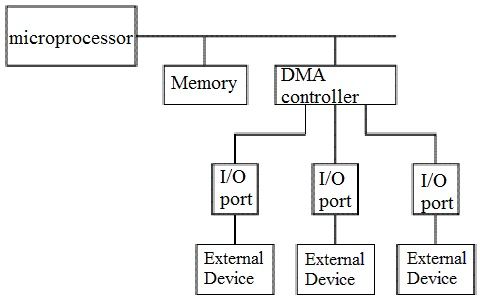

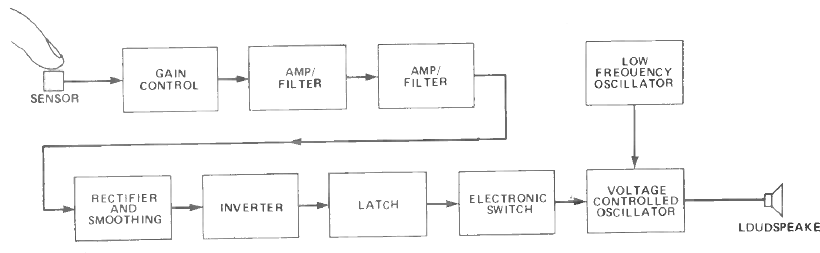

Das obige Diagramm zeigt die Funktionsweise der Rückausbreitung und ihre Funktionsweise ist unten angegeben.

- 'X' an den Eingängen reicht vom vorverbundenen Pfad

- 'W', die realen Gewichte werden verwendet, um die Eingabe zu modellieren. Die Werte von W werden zufällig zugewiesen

- Die Ausgabe für jedes Neuron wird durch Weiterleitungsausbreitung berechnet - die Eingabeschicht, die verborgene Schicht und die Ausgangsschicht.

- Der Fehler wird an den Ausgängen unter Verwendung der Gleichung berechnet, die sich durch die Ausgabe und verborgene Schichten wieder rückwärts ausbreitet. Die Gewichte werden angepasst, um den Fehler zu verringern.

Weiter vorwärts ausbreiten, um die Ausgabe und den Fehler zu berechnen. Wenn der Fehler minimiert wird, endet dieser Prozess oder breitet sich rückwärts aus und passt die Gewichtswerte an.

Dieser Vorgang wird wiederholt, bis der Fehler auf ein Minimum reduziert ist und die gewünschte Ausgabe erhalten wird.

Warum brauchen wir Backpropagation?

Dies ist ein Mechanismus, mit dem das neuronale Netzwerk in Bezug auf den jeweiligen Datensatz trainiert wird. Einige der Vorteile der Backpropagation sind

- Es ist einfach, schnell und einfach zu programmieren

- Es werden nur die Nummern des Eingangs und keine anderen Parameter abgestimmt

- Sie müssen keine Vorkenntnisse über das Netzwerk haben

- Es ist flexibel

- Ein Standardansatz und arbeitet effizient

- Der Benutzer muss keine speziellen Funktionen erlernen

Arten von Backpropagation-Netzwerken

Es gibt zwei Arten von Backpropagation-Netzwerken. Es ist wie folgt kategorisiert:

Statische Backpropagation

Statische Backpropagation ist eine Art von Netzwerk, das darauf abzielt, eine Zuordnung einer statischen Eingabe zur statischen Ausgabe zu erstellen. Diese Arten von Netzwerken sind in der Lage, statische Klassifizierungsprobleme wie die optische Zeichenerkennung (OCR) zu lösen.

Wiederkehrende Backpropagation

Die wiederkehrende Backpropagation ist eine andere Art von Netzwerk, das beim Festkomma-Lernen eingesetzt wird. Die Aktivierungen bei wiederkehrender Backpropagation werden vorwärts geleitet, bis ein fester Wert erreicht ist. Anschließend wird ein Fehler berechnet und rückwärts weitergegeben. EIN Software NeuroSolutions hat die Fähigkeit, die wiederkehrende Backpropagation durchzuführen.

Die Hauptunterschiede: Die statische Backpropagation bietet eine sofortige Zuordnung, während die Zuordnung der wiederkehrenden Backpropagation nicht unmittelbar erfolgt.

Nachteile der Backpropagation

Nachteile der Backpropagation sind:

- Backpropagation reagiert möglicherweise empfindlich auf verrauschte Daten und Unregelmäßigkeiten

- Die Leistung hängt stark von den Eingabedaten ab

- Benötigt zu viel Zeit für das Training

- Die Notwendigkeit einer matrixbasierten Methode für die Backpropagation anstelle von Mini-Batch

Anwendungen der Backpropagation

Die Anwendungen sind

- Das neuronale Netzwerk ist darauf trainiert, jeden Buchstaben eines Wortes und eines Satzes auszusprechen

- Es wird im Bereich von verwendet Spracherkennung

- Es wird im Bereich der Charakter- und Gesichtserkennung eingesetzt

FAQs

1). Warum brauchen wir Backpropagation in neuronalen Netzen?

Dies ist ein Mechanismus, mit dem das neuronale Netzwerk in Bezug auf den jeweiligen Datensatz trainiert wird

2). Was ist das Ziel des Backpropagation-Algorithmus?

Das Ziel dieses Algorithmus ist es, einen Trainingsmechanismus für neuronale Netze zu erstellen, um sicherzustellen, dass das Netzwerk trainiert wird, um die Eingaben ihren entsprechenden Ausgängen zuzuordnen.

3). Wie hoch ist die Lernrate in neuronalen Netzen?

Die Lernrate wird im Kontext der Optimierung und Minimierung der Verlustfunktion eines neuronalen Netzwerks definiert. Es bezieht sich auf die Geschwindigkeit, mit der ein neuronales Netzwerk neue Daten lernen kann, indem es die alten Daten überschreibt.

4). Ist das neuronale Netzwerk ein Algorithmus?

Ja. Neuronale Netze sind eine Reihe von Lernalgorithmen oder -regeln, mit denen die Muster identifiziert werden können.

5). Was ist die Aktivierungsfunktion in einem neuronalen Netzwerk?

Die Aktivierungsfunktion eines neuronalen Netzwerks entscheidet anhand der Gesamtsumme, ob das Neuron aktiviert / ausgelöst werden soll oder nicht.

In diesem Artikel, das Konzept der Backpropagation von neuronalen Netzen wird mit einer einfachen Sprache erklärt, die der Leser verstehen kann. Bei diesem Verfahren werden neuronale Netze aus Fehlern trainiert, die erzeugt werden, um autark zu werden und komplexe Situationen zu bewältigen. Neuronale Netze können anhand eines Beispiels genau lernen.